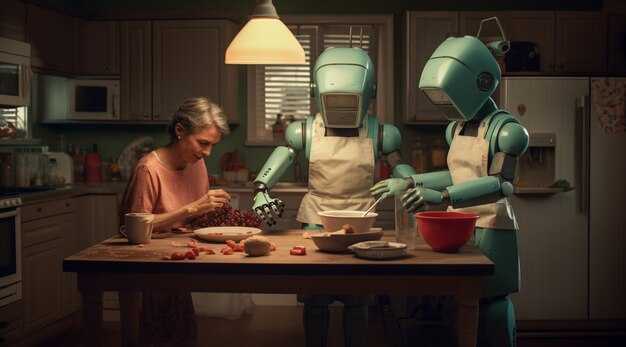

Choosing collaboration over replacement, marketers should deploy AI as a trusted assistant that handles data-heavy tasks while people steer strategy, storytelling, and relationships. choosing where AI brings value matters.

AI handles scheduling, testing, and scaling content, delivering predictable outputs and traz reliability as a guide for planners who set goals and timelines. In recent pilots, teams reported 25-40% faster iteration cycles and a 15-25% increase in successful tests moving from idea to iteration within a week.

Human creativity remains essential: artistry that understands culture and brand meaning; machines accelerate output without fully grasping the perguntas that matter to their goals, e understanding these nuances matters.

Use источник data as a compass, and keep plan aligned with safety and risk controls; the machine can crunch signals, while human teams interpret them and decide what to test next, which matters as a guide to actions.

In practice, the best path blends automation with human judgment. It helps prevent losing momentum, keeps teams focused, and answers the perguntas that arise as goals evolve. When marketing teams take ownership of creative direction and schedule experiments thoughtfully, machines shrink repetitive work and amplify impact. Begin with a 90-day pilot to evaluate time-to-publish, engagement lift, and cost per lead.

The future of sales isn’t human or AI it’s both says Bryant AI marketing expert Stefanie Boyer

Prioritize a hybrid sales engine: blend human strategist instincts with AI analytics to drive reliable results. This approach brings the best of both worlds: the behind authenticity of messaging from people and the analytic speed to analyze signals, run tests, and optimize campaigns. Prioritize the right signals and keep a clear focus on what matters, with reporting that shows the advantages of each layer.

Whats next for sales? Tie every decision to the customer experience. Using visuals and experiences grounds messaging in reality. A balance workflow reduces burnout by distributing creative tasks and data work; this balance helps everyone stay inspired while staying rigorous. Track issues and iterate quickly with reporting, answering questions and whats next for the pipeline: which channels deliver the best response, and how does the attribution model reflect their contributions.

Practical steps: run short cycles of tests every 1-2 weeks, using live data to validate hypotheses. Build dashboards for analytics and publish a weekly report with 3-5 actionable insights. Analyze the gap between forecast and reality, then adjust budgets, creative briefs, and channel bets. Keep the optimization steady by documenting what worked and what didn’t.

Bottom line: the future of sales blends human insight and machine precision. Assign a dedicated owner for balance, invest in training to preserve authenticity, and ensure visuals align with brand voice. Pose questions, collect feedback, and iterate. whats next is a repeatable loop: learn, apply, measure, and evolve, so everyone benefits from better experiences.

Identify tasks best suited for AI-driven ideation in campaigns

To streamline creative ideation without sacrificing relevance, deploy AI to generate baseline concepts, then guide humans to polish and own the final messaging. If youre strapped for time, AI can draft dozens of variants for each asset, enabling rapid tests and learning; as campaigns evolve, the loop can become a core part of the workflows, helping to discover patterns without exhausting people. It doesnt replace human judgment; AI outputs are a smarter tool to make the team more productive and to support making strategic decisions.

- Headline and copy concept generation: AI drafts 50-200 headline variants per brief across tones and value props; use tests to identify top performing options. Editors pick 5-10 to test next, which cuts down manual drafting time and reduces burnout.

- Blog content angles and outlines: AI proposes angles, hooks, meta topics, and outlines for blog posts, ensuring coverage of diverse perspectives while preserving brand voice.

- Subject lines and email copy: AI generates 20-40 subject lines and multiple body variants per segment; tests reveal which combinations drive open rates and engagement.

- Audience problem-solving framing: AI surfaces angles framed around solving concrete user problems, helping messaging stay relevant across channels and contexts.

- Personalized concept sets for segments: generate tailored variants for different personas or industries; templates get reused and adapted quickly without starting from scratch.

- Downstream asset ideation: propose visual directions, layouts, and micro-copy for landing pages, banners, and video scripts to maintain consistency across downstream assets.

- Testing plans and hypotheses: AI drafts test hypotheses, KPI targets, and measurement plans; run tests to validate and refine, without analyzing data manually in the first pass.

- Workflow integration and governance: embed AI outputs into existing workflows with prompts and guardrails; advanced configurations keep control on the left side while enabling heavy iteration.

- Oversight and evaluation loops: define criteria to evaluate ideas, monitor seen signals, and iterate rapidly with human oversight guiding brand alignment.

- Burnout reduction and capacity planning: automate repetitive ideation tasks to reduce burnout, freeing people for strategic, high-value storytelling and making room for creative experimentation.

Benchmark metrics for evaluating AI-generated vs human-created content

Recommendation: implement a hybrid evaluation protocol that combines measurable automated metrics with human judgments, and run testing in parallel for ai-powered and human-created content. Use a two-tier score: quantitative (0–5) for relevance, factuality, and readability; and qualitative (1–5) for emotionally resonant and brand-aligned messaging. Target an average automated score of 4.0+ and a qualitative score of 4.0+ across 200 items per batch. Calibrate with a humanai baseline to align machine output with real-world expectations and ensure it does not feel like replacement, but rather a tool that takes decision-making to the next level, and optimize for outcomes that affect the audience together with humans.

Measurable metrics cover content quality and impact. Track factual accuracy (error rate under 2%), semantic alignment (BERTScore above 0.75), readability (Flesch-Kincaid level 8–12 for broad audiences), sound brand voice (tone and vocabulary consistency), and message coherence. Measure engagement: time on page, scroll depth, and CTA click-through rate. Include scheduling efficiency: time-to-publish per piece and cadence adherence; log how ai-powered variants affect overall publishing velocity. AI content often lacks domain nuance, so incorporate guardrails that force checks on specialty topics. The scoring table should be transparent so everyone can understand the level of quality and affect content strategy across channels.

Testing protocol emphasizes realism and diversity. Use 250 items per batch across categories such as beverage campaigns and product tutorials, with both long-form articles and microcopy. Randomize presentation order, randomize AI-generated vs human-created content, and collect two sets of ratings from independent panels to improve reliability. Track inter-rater reliability and aim for Cronbach’s alpha above 0.7. Ensure the process molds toward consistent outcomes rather than drifting into a subjective mold, and document how each piece affects scheduling, distribution, and overall decision-making.

Decision-making blends AI and human input. The dashboard presents scores for AI-generated and human-created content side by side, and allows either track to trigger escalation to a human reviewer when risk thresholds are crossed. Working together, teams set guardrails to avoid denials of user value; content choices optimize for impact without denying the value of human insight. Be clear that AI is not a replacement, but a partner in brainstorming, planning, and final polish. Use a humanai benchmark to ensure the system can adapt to nuanced contexts and emotional signals that machines still struggle with.

Practical steps to implement: 1) define measurable metrics and thresholds; 2) run a six-week pilot; 3) build a live dashboard; 4) run regular cross-channel testing; 5) iterate on feedback. Schedule weekly reviews where leadership and content creators review top AI vs human items, and adjust the mold or workflow to keep content aligned. 6) track impact on revenue, engagement, and brand perception. This approach helps everyone understand what level of quality to expect, and how ai-powered tools affect decision-making in real campaigns, including content for beverage brands and beyond. Finally, think about governance: avoid denying the value of human input.

Blending storytelling with data: building hybrid creatives that convert

Start with a concrete rule: pair a tight narrative hook with a rapid data test in a two-week sprint. Draft a 120-second story arc that aligns with a single offer, then validate it with two landing-page variants and measure result, including seconds to first interaction and conversions. Run three micro-tests and iterate based on outcomes within 14 days. Structure the workflow so workshops train teams to apply both craft and analytics, and document lessons in a shared table.

Nos bastidores, mapeie os pontos narrativos aos sinais de comportamento: profundidade de scroll, fluxos de cliques, tempo na página, risco de abandono e micro-conversões. Os ajustes subtis ao tom, às imagens e ao ritmo podem gerar um grande resultado sem reformular profundamente os recursos. Quando surgem problemas, resolva-os rapidamente através de testes, e não através da negação; um plano de testes claro e transparente reduz a frustração e mantém os alunos e colegas envolvidos. Se as respostas estagnam, pode ser frustrante; os testes revelam o porquê. Se uma frase falha, um teste rápido revela uma alternativa melhor. O amor pela criatividade deve equilibrar-se com a disciplina dos dados para evitar transformar o trabalho numa rotina aborrecida.

Segundo Boyer, a criatividade floresce onde a estrutura apoia a exploração; alinhe a tabela de experiências com o briefing criativo, garantindo que cada ideia tenha um teste e uma hipótese. Na prática, use uma tabela simples para capturar pressupostos: sinais da audiência, gancho narrativo, formato do recurso e métrica de sucesso; reveja semanalmente com alunos e colegas. À medida que os dados chegam, os insights atuais devem orientar as decisões, não silenciar a imaginação. Se verificar uma alta taxa de abandono num segmento, pivote o ângulo da história rapidamente, em vez de negar os sinais. Esta abordagem requer um ritmo disciplinado e repetível que as equipas podem assumir.

| Element | Ação | Métrica | Prazo temporal |

|---|---|---|---|

| Título da narrativa | Testar *hooks* e frases de abertura | CTR, tempo na página, segundos até à primeira interação | 14 dias |

| Recurso visual | Avalie a imagiologia e a paleta de cores | CTR, engagement rate | 14 dias |

| Texto de CTA | Formulação de experiência | Conversões, registos | 14 dias |

| Ritmo do arco narrativo | Pontos de A/B na narrativa | Profundidade de scroll, taxa de conclusão | 14 dias |

| Ciclo de retenção | Email de seguimento narrativo | taxa de retorno, taxa de churn | 28 dias |

A abordagem híbrida gera ganhos de eficiência impressionantes: a narrativa unificada e o aperfeiçoamento orientado por dados reduzem o desperdício e aceleram os sucessos. Cria uma área colaborativa onde estudantes e profissionais partilham feedback, cortando o tempo do conceito ao resultado em segundos em projetos de ritmo acelerado. Ao manter um equilíbrio entre o amor pelo trabalho artesanal e o rigor analítico, as equipas reduzem o atrito e a rotatividade, construindo um caminho repetível para a conversão.

Configuração passo-a-passo para um fluxo de trabalho criativo assistido por IA

Comece com um briefing padronizado e um modelo reutilizável para orientar cada recurso. Coloque o rascunho inicial do lado esquerdo do seu espaço de trabalho, garantindo que a voz original permaneça intacta enquanto o alimenta ao Jasper para uma idealização rápida. Use este briefing de uma página para definir o público, a oferta e um resultado mensurável; vincule isso a um KPI primário para manter as campanhas focadas e evitar desvios.

Passo 2: Construir um modelo criativo modular para outputs de alto volume: título, subtítulo, corpo de texto, CTA e blocos de estímulo visual. Predefinir tom, extensão e diretrizes da marca; codificar esses aspetos em prompts para que a IA possa fornecer rascunhos consistentes e, em seguida, sujeitá-los a revisão humana. Eis como estruturar prompts para garantir a consistência com o Jasper e outras ferramentas, preservando ao mesmo tempo a voz da marca em todas as campanhas.

Passo 3: Dados e análises: ligar fontes (CRM, plataformas de anúncios, análise web). Definir onde extrair sinais e onde entregar recursos aos canais; configurar dashboards que mostrem métricas da esquerda para a direita; monitorizar os efeitos a jusante nas conversões; usar análises para quantificar o impacto dos recursos assistidos por IA no envolvimento.

Passo 4: Configuração do conjunto de ferramentas: atribuir o Jasper à ideação e aos primeiros rascunhos, um verificador de visão para garantir o alinhamento com os problemas dos clientes; identificar onde os editores humanos devem intervir; definir SLAs para revisões; garantir aprovações das equipas de marketing e produto para acelerar as decisões de licitação e a iteração de ideias. Este passo é fundamental para evitar desvios e manter a mensagem alinhada com os objetivos.

Passo 5: Controlo de qualidade e governação: manter um tom pessoal e autêntico, injetando toques humanos; manter uma voz real; etiquetar ativos com metadados; implementar uma verificação para aferir se a mensagem pode afetar os resultados a jusante; verificar a exatidão das alegações e dos pontos de dados.

Passo 6: Lançar e medir: executar testes rigorosos e controlados em campanhas extensas e de alto volume; usar testes A/B para comparar variantes assistidas por IA com a base de referência; monitorizar ganhos em análises; ajustar estratégias de licitação com base nos primeiros resultados; alinhar com os vendedores para garantir ciclos de feedback para resultados posteriores. Os testes A/B mostram variantes com melhor desempenho do que os rascunhos manuais.

Passo 7: Otimização e dimensionamento: codificar padrões comprovados em modelos reutilizáveis; quando as métricas melhorarem, dimensionar para novos canais; usar ciclos de descoberta para revelar novos formatos e silhuetas criativas; manter um toque pessoal e misterioso para manter a ressonância do público.

Qualidade de dados, governação e conformidade para um marketing de IA responsável

Audite as fontes de dados agora e implemente barreiras de qualidade automatizadas que bloqueiem dados de baixa qualidade ou sem consentimento de modelos alimentados por IA. Crie um catálogo de dados com linhagem, consentimento e etiquetas de atualização para impulsionar proteções em todos os fluxos de trabalho.

- Qualidade e proveniência dos dados: Construa um catálogo de dados centralizado com campos para origem, última atualização, consentimento e restrições de utilização. Aplique regras de validação no ponto de entrada da ingestão e nas ligações periféricas para reduzir resultados desviantes e melhorar a autenticidade. Utilize ciclos de feedback para aprender e ajustar as regras à medida que os dados se alteram.

- Governação e fluxos de trabalho: Defina funções, pontos de aprovação e controlo de alterações para atualizações de modelos. Mapeie os pontos de decisão em fluxos de trabalho explícitos para que as equipas possam agir rapidamente ao reprocessar ou atualizar criativos. É por isso que especifica se os dados podem ser usados para formação e estabelece regras de retenção, para que as equipas permaneçam alinhadas.

- Privacidade e consentimento: Manter o estado de adesão para campanhas de e-mail, respeitar as preferências de não contacto e aplicar DPIA para utilização de marketing de IA. Utilizar a pseudonimização para análises, mantendo os dados utilizáveis para aprendizagem. Se um utilizador não consentir em determinado processamento, bloquear esse caminho de processamento.

- Processamento de sinais em tempo real: No modo de processamento em tempo real, configure pipelines de streaming que monitorizam os fatores de churn e os sinais fora do alvo, e re-segmentam ou pausam campanhas antes do envio. Associe as saídas de volta ao catálogo para manter os dados alinhados e auditáveis.

- Autenticidade e resultados: Aplicar atribuição e registo para mostrar como um resultado foi gerado; exigir supervisão humana para decisões criativas e marcar as partes geradas por IA para preservar a transparência.

- Aprendizagem e pequenos testes: Execute pequenas coortes piloto para validar regras de dados e prompts de modelos; use o aprendizado para reforçar os critérios de qualidade e reduzir o desvio antes de escalar para mercados maiores. Isso ajuda a construir confiança de que o sistema responde atenciosamente ao feedback.

- Auditorias e relatórios: Agende verificações de conformidade regulares, mantenha registos imutáveis e publique dashboards concisos para as partes interessadas. Inclua visuais de linhagem de dados, estado de consentimento e histórico de versões de modelos para demonstrar governação.

- Impacto e otimização: Monitorize métricas como a redução da taxa de abandono, o aumento do envolvimento e as conversões; associe as melhorias a alterações específicas nas regras e iterações do modelo, para poder demonstrar vitórias em resultados de marketing importantes.

- Governação centrada em “drivers”: definir “drivers” como atributos de público-alvo e variantes criativas; limitar os prompts a conteúdo compatível com as políticas; monitorizar quais os “drivers” que proporcionam os melhores resultados e encaminhar insights de volta para os fluxos de trabalho. Isto mantém as campanhas alinhadas com os valores da marca e as regras de privacidade.

- Deteção de anomalias e sinais de tosse: Implementar a deteção de anomalias para identificar picos irregulares; tratar uma tosse nas métricas como um sinal para suspender o processamento e rever a proveniência dos dados, garantindo uma ação corretiva rápida.

AI vs Human Creativity – Can Machines Really Replace Marketers?">

AI vs Human Creativity – Can Machines Really Replace Marketers?">