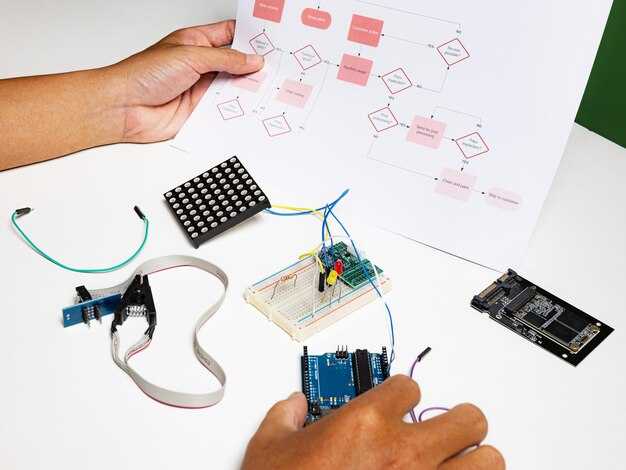

Comece com um objetivo claro: defina a tarefa, as métricas de sucesso e como irá verificar os resultados. existe a specific apontar e join elaborar por engenheiros um assinado prompt spec. Para reduzir o desvio, portanto estabelecer um prompt de linha de base e comparar resultados. Reunir resources in english e outros linguagem materiais para ancorar expectativas e reduzir o desvio. Use um diferente estilo de entrada para cada variante de prompt para comparar resultados, uma vasta gama de domínios.

Adote um fluxo de trabalho focado na técnica: crie prompts com uma specific intenção, restrições e sinais. Estruture as instruções em frases curtas, depois execute. check face a um conjunto de validação para confirmar coerente resultados, altamente acionáveis; esta abordagem tem sido comprovado que escala entre domínios. Crie templates que escalam: um prompt base, mais alguns adaptadores para domínios como código, escrita ou interpretação de dados. Os resultados revelarão onde apertar restrições e adicionar exemplos.

Iterar em ciclos: testar um pequeno conjunto de prompts controlado, comparar resultados, e ajustar. Manter as instruções concisas, usar specific sinalização e evite ambiguidades. Utilize uma destas abordagens: zero-shot, few-shot, ou sequências de raciocínio; se for usado raciocínio em cadeia, forneça um curto, coerente racional para orientar o modelo.

Mantenha uma biblioteca de prompts dinâmica que faça o rastreio de prompts, contextos, inputs e resultados. Etiquete os prompts por domínio, dificuldade e resources utilizados; manter um registo de alterações e versões assinadas para garantir o alinhamento entre as equipas. Para tarefas multilingues, manter prompts paralelos em english e outras línguas e verifique a paridade da tradução para evitar desvios. Aplique uma leve etapa de controlo de qualidade, ou uma rápida check para detetar resultados coerentes numa fase inicial.

Guia Prático de Engenharia de Prompts

Definir um objetivo concreto e realizar um piloto rápido com cinco exemplos para verificar as respostas. Utilizar uma rubrica simples para classificar a relevância, a clareza e a exatidão factual, e documentar os resultados para cada pedido.

Criar uma declaração de intenções assinada e краткое para prompts, aplicando posteriormente uma estrutura fixa: Contexto, Instrução e Pergunta. Manter o breve contexto limitado a 1–2 frases e indicar a ação na instrução.

Recolher fontes e conjuntos de dados que abrangem contextos linguísticos, incluindo documentação oficial, pedidos de clientes e transcrições de conversas. Estas fontes expandem as capacidades de produzir resultados mais precisos, que os modelos frequentemente não compreendem, e os engenheiros de inteligência artificial estão entusiasmados com a cobertura mais ampla.

Adote uma abordagem estruturada: use um modelo de prompt fixo, execute 10 a 20 prompts, compare as respostas com uma base de referência verificada e registe lacunas para refinação. Traduza as conclusões em recomendações claras.

Manter um histórico de versão assinado e completo de prompts, controlar alterações com notas concisas e creditar fontes utilizadas.

Partilhe modelos entre equipas, recolha feedback e mantenha a paixão pela melhoria em alta. Se os clientes pedirem atualizações, adapte os modelos e refine as instruções em conformidade.

Definir critérios de sucesso concretos para cada solicitação

Defina um critério de sucesso concreto para cada solicitação e anexe-o às saídas para orientar a avaliação. Isto mantém a tarefa focada e acelera a iteração, portanto pode detetar rapidamente lacunas e ajustar. Associe os critérios à versão da solicitação e ao contexto da área, especialmente quando dados de pacientes estão envolvidos. Pense em termos de resultados explícitos e testáveis, em vez de garantias vagas, para que possa comparar solicitações entre ficheiros e versões com consistência.

Utilize uma rubrica concisa que abranja o que produzir, como formatar e como avaliar a qualidade. Garanta que cada critério seja limitado em escopo (limitado) e ligado ao objetivo do utilizador, pois os outputs generativos variam consoante o prompt. Esta abordagem ajuda a evitar feedback ambíguo e apoia a tomada de decisões rápidas sobre os próximos passos.

- Esclarecer o âmbito da tarefa e definir uma declaração de sucesso.

- Objetivo: Descrever o objetivo numa única frase e incluir uma declaração clara (declaração) do que conta como um resultado bem-sucedido (outputs).

- Okay, I understand. Just provide the text you want me to translate into Portuguese (Portugal). I will focus on providing a natural and accurate translation, respecting the original tone, style, formatting, and line breaks.

- Restrições: se os dados forem limitados, indique o que pode ser usado e o que deve permanecer excluindo detalhes confidenciais (нужно).

- Decidir formatos de saída, ficheiros e metadados.

- Resultados: defina as entregas exatas (por exemplo, um resumo conciso, um JSON estruturado ou uma lista com marcadores) e os respetivos formatos; liste os campos obrigatórios para cada resultado.

- Ficheiros: especifique onde armazenar os resultados (ficheiros) e como devem ser nomeados para fácil recuperação; inclua um exemplo de caminho ou convenção de nomenclatura.

- Versionamento: exigir uma tag de versão (version) e manter um breve registo de alterações para monitorizar iterações.

- Definir métricas de qualidade mensuráveis e limiares de aceitação

- Métricas: precisão, integridade, relevância e oportunidade; atribuir limiares numéricos (ex: >= 90% de relevância, <5% erro factual).

- Limiares: fornecer critérios de aceitação concretos e um plano de contingência caso um limiar não seja atingido.

- Diferenças por domínio: adaptar critérios para diferentes domínios (diferentes áreas) e documentar quaisquer ajustes específicos do domínio.

- Definir método de avaliação e fontes

- Avaliação: especificar se humanos ou verificações automatizadas julgarão cada critério; apresentar uma pequena checklist (fontes) para os revisores.

- Fontes: exigem fontes credíveis (istochniki) e uma lista (список) de referências utilizadas para verificar factos; evite alucinações, fazendo verificações cruzadas com fontes fidedignas.

- Sem dados externos: garantir que as avaliações se baseiam apenas nas saídas fornecidas (sem dependência de entradas externas e desconhecidas).

- Documentar os detalhes da implementação e o processo de revisão

- Documentação: anexar uma breve rubrica a descrever como pontuar cada critério; incluir exemplos de instruções e amostras de resultados para garantir (garantir) consistência entre equipas.

- Colaboração: envolver revisores de diferentes (diferentes) áreas (áreas) para captar perspetivas diversificadas e reduzir o viés.

- Ciclo de feedback: identificar diferenças acionáveis e propor melhorias concretas para a próxima versão do prompt.

- Forneça modelos e exemplos práticos.

- Modelo: Inclua uma declaração pronta a preencher, resultados esperados e limites de aceitação; assegure-se que referencia ficheiros, versão e lista de fontes.

- Exemplos: mostrar um prompt mínimo vs. um prompt melhorado e comparar os resultados em relação aos critérios; usar contextos do mundo real (por exemplo, para um paciente) para ilustrar a aplicabilidade.

- Sugestão de automação: crie um arnês de teste leve que execute prompts, capture saídas e assinale automaticamente falhas de critérios.

Escolha entre instruções diretas e prompts baseados em exemplos

Prefiro instruções diretas para tarefas claramente definidas que requerem respostas nítidas e previsíveis; emparelhá-las com prompts baseados em exemplos para ilustrar estilo de linguagem, formatação e caminhos de decisão, melhorando a comunicação e o foco sobre as restrições.

As instruções diretas destacam-se quando os critérios de sucesso são explícitos: formato fixo, comprimento preciso ou uma checklist. Para tarefas de linguagem, adicione 2–4 exemplos que demonstrem tom, estrutura e como lidar com exceções; pense em casos extremos e evite повторяться. No методе design, mantenha a diretiva concisa e ancore os exemplos ao mesmo objetivo para reforçar a consistência entre as respostas.

Uma abordagem híbrida reforça a resiliência: comece com uma diretiva compacta e continue com alguns exemplos direcionados. Isto ajuda a gerir novas tarefas e alcança uma geração fiável, orientando simultaneamente a linguagem, o tom e a estrutura. As recomendações incluem rever os resultados, atualizar as instruções e incluir novos exemplos e atualizar os recursos com as últimas atualizações para abranger o espectro de cenários.

| Aspecto | Instruções Diretas | Prompts Baseados em Exemplos |

|---|---|---|

| Nitidez | Critérios explícitos e formato fixo | Mostra como lidar com variações com exemplares definidos. |

| Quando usar | Tarefas bem definidas; resultados de rotina | Tarefas de análise criativas ou de resposta aberta |

| Construção | Uma diretiva mais restrições | 2–4 exemplos ilustrando casos limite |

| Risks | Sobreajuste a um único caminho | Desviar caso os exemplos divirjam; ter atenção para não se repetir. |

| Evaluation | Adesão ao formato; critérios objetivos de sucesso | Qualidade de estilo; alinhamento com exemplos |

Estruture prompts de várias etapas com passos de raciocínio claros.

Escreva um prompt em quatro partes que solicite raciocínio explícito em cada etapa para produzir ответы e outputs verificáveis. Inclua uma justificação concisa após cada etapa e recolha примеров de prompts bem-sucedidos em várias línguas. Este fluxo de trabalho de промпт-инжиниринга produz outputs adequados para auditoria e fácil comparação com источники e o seu аккаунт trail.

Passo 1 – Definir o objetivo e as restrições

Objetivo: Traduzir o seguinte texto para português de Portugal. Limites: Limitação de tokens, restrições de privacidade para dados de saúde e a versão de idioma desejada (versões linguísticas). Incluir fontes de dados (fontes) e saídas necessárias (respostas, exemplos). Indicar quem irá rever os resultados e como os preconceitos podem afetar as decisões (preconceitos).

Passo 2 – Decompor em diferentes subtarefas

Divida o objetivo principal em 3–5 subtarefas concretas com entradas e saídas independentes. Para cada subtarefa, inclua o formato de entrada, a saída esperada e uma justificação breve. Garanta a cobertura em domínios como programação e cuidados de saúde, e teste com diferentes contextos para fortalecer a robustez.

Passo 3 – Exigir raciocínio e formato de saída

Solicitar uma breve justificação após cada subtarefa e uma recomendação final. Incluir uma variante zero-shot, se necessário. Instruir o modelo a fornecer respostas e uma justificação compacta para cada etapa, depois apresentar um resultado final conciso. Não revelar nenhum monólogo interno; pedir uma justificação curta que apoie as decisões e citar fontes, quando aplicável.

Passo 4 – Validação e verificações de enviesamento

Incorpore verificações contra enviesamentos através da validação cruzada com múltiplas fontes e apresentando diferentes perspetivas. Exija uma pequena lista de contrapontos ou opções alternativas, destacando as potenciais limitações devido a dados ou contexto limitados. Adicione uma verificação de sanidade para confirmar se os resultados estão alinhados com as normas de saúde e as melhores práticas de codificação.

Passo 5 – Entregáveis e avaliação

**Formato:** * **Respostas:** * Clareza dos Objetivos: (Insuficiente/Suficiente/Excelente) * Correção das Subtarefas: (Incorreto/Parcialmente Correto/Correto) * Qualidade da Justificação: (Fraca/Adequada/Forte) * Alinhamento com a Fonte: (Nulo/Parcial/Total) * **Exemplos:** * Clareza dos Objetivos: (Insuficiente/Suficiente/Excelente) * Correção das Subtarefas: (Incorreto/Parcialmente Correto/Correto) * Qualidade da Justificação: (Fraca/Adequada/Forte) * Alinhamento com a Fonte: (Nulo/Parcial/Total) * **Referências:** * Clareza dos Objetivos: (Insuficiente/Suficiente/Excelente) * Correção das Subtarefas: (Incorreto/Parcialmente Correto/Correto) * Qualidade da Justificação: (Fraca/Adequada/Forte) * Alinhamento com a Fonte: (Nulo/Parcial/Total) **Notas de Auditoria para Rastreamento de Conta:** * Clareza dos Objetivos: (Insuficiente/Suficiente/Excelente) * Correção das Subtarefas: (Incorreto/Parcialmente Correto/Correto) * Qualidade da Justificação: (Fraca/Adequada/Forte) * Alinhamento com a Fonte: (Nulo/Parcial/Total) **Expansões Opcionais:** * Linguagens (VERSÃO): \[Lista de Linguagens] * Tecnologias: \[Lista de Tecnologias].

Okay, I understand. Just provide the text you want me to translate into Portuguese (Portugal). Objetivo: conceber um plano de cuidados para um perfil de paciente em saúde, Contexto: dados limitados, Restrições: tokens limitados, privacidade, Versões linguísticas: linguísticas, Fontes de dados: fontes, zero-shot: sim; Resultados: respostas, exemplos; Passos: 1) definir entradas de sub-tarefas; 2) para cada sub-tarefa dar justificação breve; 3) compilar recomendação final; 4) anexar referências; 5) registar notas de auditoria para o trilho de аккаунт.

Variante de exemplo para zero-shot e diferentes contextos linguísticos: Utilize o mesmo esqueleto para gerar resultados que possam ser comparados entre tecnologias e sistemas, garantindo formatos idênticos e compatibilidade com diferentes bases de dados e fluxos de trabalho de programação. Esses prompts apoiam a produção de respostas consistentes em diferentes plataformas e, especialmente, ajudam a otimizar fluxos de trabalho tanto em projetos de saúde como de programação.

Otimizar o contexto: orçamento de tokens e filtragem de relevância

Recommendation: Alocar um orçamento fixo de tokens para o contexto e podar o histórico para o essencial. Para tarefas típicas, apontar para 2048 tokens no contexto total e reservar 20-30 tokens para pós-geração e verificações; escalar para 4096 tokens para interações mais longas e multi-turno. Manter disciplina para evitar inchaço e manter o contexto focado no núcleo da tarefa; isto reduz o ruído e impede que o modelo crie detalhes irrelevantes.

Definir um filtro de relevância que se ajuste ao âmbito da tarefa e aos idiomas. A partir da intenção da tarefa, reunir fontes candidatas e, em seguida, calcular embeddings para medir a semelhança com o prompt do utilizador. Para modelos языковых, manter as топ-3 a топ-5 fontes e descartar o resto. Registar decisões em таблицы para rastreabilidade e debugging, para que se possa auditar o porquê de certas fontes recuperadas no Context terem sido escolhidas.

Equilibre as fontes com a extensão do prompt. Crie uma etapa de recuperação que anexe apenas excertos altamente relevantes e resumos curtos, em vez de documentos completos. Se as fontes forem longas, use a tradução para produzir extratos concisos na língua alvo e, em seguida, anexe esses excertos ao prompt. Esta abordagem ajuda o modelo a concentrar a atenção no conteúdo mais informativo e evita partes desnecessárias do texto. O resultado: menos ruído e uma maior probabilidade de que o modelo apresente respostas precisas para a tarefa.

Pós-geração Verificações reduzem o risco de desvio. Após a geração, podar o conteúdo de raciocínio em cadeia na resposta visível e fornecer uma resposta sucinta ou um resultado estruturado. Se necessário, armazenar o percurso de raciocínio num registo separado para apoiar a depuração sem expor as deliberações internas ao utilizador final.

Acompanhe o progresso com métricas concretas. Compare com artigos sobre geração aumentada por recuperação e atualize as rotinas em conformidade. Utilize as melhorias de compreensão como um sinal primário e registe prompts проб e resultados em tabelas para observar tendências ao longo do tempo. Quando atualizar os cursos, partilhe diretrizes resumidas e exemplos detalhadamente ilustrados para manter as equipas alinhadas; incorpore etapas de tradução para suportar fluxos de trabalho multilingues e reveja frequentemente o orçamento de tokens para garantir relevância e eficiência.

Na prática, esta abordagem mantém o âmbito restrito e focado. Evite desviar-se para небо de contexto excessivo; mantenha мысли claras, filtrando o ruído e alinhando quaisquer сгенерирует outputs com a tarefa principal. Ao aplicar дисциплина, desde o enquadramento da tarefa até à pós-geração, obtém respostas mais consistentes e uma compreensão mais aguda понимания em различный языковых scenarios, mantendo um foco prático прежде всего nas necessidades do utilizador и o nível de detalhe necessário. Cada refinamento impulsiona o seu sistema para outputs de higher品質, com проб ponderadas e melhorias medidas em отсылочные papers e cursos para ongoing обучение.

Prompts de avaliação de design e casos de teste que reflitam tarefas reais

Crie prompts de avaliação de design que reflitam tarefas reais, fundamentando-os em fluxos de trabalho reais de utilizadores e resultados mensuráveis. Comece por identificar os problemas mais recentes dos utilizadores no backlog, capture ideias e sugestões, e compile um conjunto de prompts que ajude a modelar respostas com passos concretos, justificações e resultados. Inclua domínios como pesquisas de produtos da Amazon e fluxos de checkout para refletir o trabalho típico e valide os prompts em relação às intenções reais dos utilizadores.

Estruture cada caso de teste como uma mini-tarefa: entrada, passos do processo e resposta final. Utilize fixtures de dados prontos para recarregar, para que os testes se mantenham atualizados quando os catálogos são atualizados. Para cada caso, especifique duas ou três consultas concretas e defina critérios de avaliação: relevância, coerência e qualidade da justificação. Crie uma rubrica que os revisores possam aplicar rapidamente, e ligue cada teste a um cenário real de suporte ou de compra, para garantir o alinhamento com os resultados reais do utilizador. A abordagem ajuda as equipas de engenharia a comparar os resultados nas últimas iterações do pipeline de criação de prompts e que passos de prompting ajudarão a garantir a transparência do processo.

Ao criar prompts, elabore um conjunto de sinais de avaliação que vão além da precisão superficial. Concentre-se na consistência, rastreabilidade do raciocínio e alinhamento com a intenção. Crie respostas âncora e rubricas de pontuação, e registre prompts, respostas e veredictos. Use recursos e инструменты para agregar conjuntos de dados realistas a partir de logs e referências públicas; forneça acesso para equipas multifuncionais (engenharia, produto, QA) para rever e iterar. Esta abordagem apoia o desenvolvimento de estratégias de prompts robustas que permanecem fiáveis à medida que as entradas evoluem, особенно в рамках engineering и промптинга.

Operacionalize a avaliação com um mecanismo leve que execute cada caso de teste, registe as instruções, as saídas do modelo e as pontuações e acione o recarregamento de dados quando as entradas mudam. Use os resultados mais recentes para impulsionar melhorias na elaboração e para informar o próximo ciclo de iterações. Mantenha um repositório dinâmico de предложения, идеи e consultas atualizadas para acelerar o aperfeiçoamento. Garanta que a documentação e os materiais de formação ajudem as equipas a compreender como interpretar os resultados e como reutilizar os testes para consultas e recomendações de produtos ao estilo da Amazon.

Guia de Engenharia de Prompt – Técnicas, Dicas e Melhores Práticas">

Guia de Engenharia de Prompt – Técnicas, Dicas e Melhores Práticas">