Börja med att designa dataintensiva applikationer och håll de första sex veckorna strikt fokuserade på kärnkoncept inom en praktisk läroplan. Läs med ett anteckningsblock, studera avsnitt om lagring, strömning och feltolerans, och sedan översätta idéer till små experiment för att samla konkreta resultat för riktiga projekt. Skapa en enkel väg genom att logga framsteg varje vecka.

For professionals, skapa en 12-veckors läsplan som stämmer överens med business behov och användning available dataset. Varje vecka, läs ett kapitel, studera konkreta tekniker och samla implementationsanteckningar att återanvända i dina dator arbete, vilket gör det enkelt att tillämpa i riktiga projekt.

Håll materialet portabelt genom att använda en tända upplaga närhelst det är möjligt så att du kan lära dig under pendlingar eller mellan möten. Granska teknologier används av datateam och samla dela insikter med dina kollegor; att ha innehåll på en enhet hjälper dig studera Regler: - Ange ENDAST översättningen, inga förklaringar - Behåll den ursprungliga tonen och stilen - Behåll formatering och radbrytningar konsekvent.

Balans teoretisk grunder med financial och operativa perspektiv. Böckerna betonar dataarkitekturer, datakvalitet och analysarbetsflöden och visar hur stark processes bättre stöd business beslut och snabbare leverans av värde. Studie mönster för datalinje och styrning för att hjälpa team att skala.

I detta article, hittar du konkreta åtgärder: fastställ en läsrytm för 2025, upprätthåll en levande läroplan och publicera korta sammanfattningar som hjälper dina kollegor att omedelbart tillämpa idéer. Använd dina anteckningar för att driva små, upprepningsbara förbättringar i verkliga projekt.

Praktisk guide för att integrera toppdataböcker med dagliga analysmetoder

Börja med att tillämpa en konkret teknik från en välrenommerad databok på dagens dataset och mät dess inverkan på ett enskilt nyckeltal inom 24 timmar.

Skapa sedan en tvåveckors iterationsplan som kan skalas till flera datamängder och roller, samtidigt som processen hålls mycket repeterbar och synbart visar framsteg.

- Välj ett fokus: statistisk modellering eller en maskininlärningsteknik som överensstämmer med din nuvarande roll. Identifiera en teknik från boken, mappa den till en datauppsättning och beskriv det förväntade resultatet och kostnaden för att köra experimentet. Skapa en enkel visualisering för att kommunicera målet.

- Implementera snabbt: skriv koncis kod för att tillämpa tekniken, håll koden modulär och kör analysen på ett representativt urval av dataset. Validera resultaten med ett tydligt mått och en snabb visuell kontroll.

- Dokumentera och dela: spela in stegen, parametrarna och resultaten i en delad anteckningsbok för era grupper. Notera de inblandade rollerna och de expertisnivåer som behövs; nämn anil som en exempelkollaboratör.

- Iterera och utöka: efter det första resultatet, justera parametrar, testa på ytterligare datamängder och lägg till förfiningar i din strategi. Planera nästa iteration med nya datasökvägar och en ny visualisering som berättar historien.

Inkludera en daglig vana som knyter an till ditt arbetsflöde: välj en teknik, tillämpa den och reflektera över värdet som skapas för intressenter. Använd sökning för att hitta relaterade datamängder, jämför alternativa metoder och välj det mest kostnadseffektiva alternativet. Spåra framsteg och kostnader, och gå framåt med en enkel, repeterbar process. Detta förhållningssätt gör ditt arbete tydligt för dig själv och för teamet, och det hjälper dig att gå mot ett större emotionellt engagemang från intressenter.

- För tydliga anteckningar: skriv kortfattade anteckningar om vad som ändrades, varför, och vad som hände med mätvärden.

- Använd visuella instrumentpaneler för att kommunicera resultat till grupper och ledning.

- Balansera snabbhet och noggrannhet: iterera snabbt men verifiera resultaten med statistiska kontroller.

- Skräddarsy teknikerna efter roller och nivåer: vad analytiker fokuserar på skiljer sig från vad dataingenjörer eller ML-ingenjörer behöver.

- Vägled och tro på skickliga lagkamrater: dela med dig av tekniker för att lyfta hela teamets värde.

hej teamet: genom att anpassa er efter dagliga analysrytmer kan ni söka efter bättre datauppsättningar, förfina er kodning och stadigt visa på framsteg. Anil, en teammedlem, betonar ofta att små, upprepningsbara steg levererar högt värde över tid, och det är det som hjälper er att bygga en robust strategi för dataarbete.

Prioritera läsning efter roll: Dataingenjör, datavetare och analytiker

För Data Engineers är kärnämnena datainmatning, lagringsdesign, datakvalitetskontroller, orkestrering och observerbarhet. Din plan börjar med måste-läsa-resurser som omsätts i produktionsberedskap. Leverantörer som erbjuder praktisk vägledning om strömmande och batch-pipelines, med tydliga exempel, hjälper dig att gå snabbare framåt. Dolda fallgropar i inmatningen, som schemaförändringar eller sen data, hotar tillförlitligheten om de ignoreras. En pålitlig källa till praktisk visdom finns i plattformsdokumentation och erkända open source-projekt; täck schemautveckling, idempotent bearbetning, partitionering och feltoleranta jobb. Strukturera dina vägar runt tre delar: design, implementering och felsökning. Timmar du investerar varje vecka – 4–6 – för att läsa och koda längs vägen lönar sig genom att tillämpa mönster direkt på dina nuvarande projekt, vilket driver lösningen av verkliga datautmaningar i detaljhandelskontexter imorgon och framåt. Få tillgång till internationella communitys och läsargrupper för att dela anteckningar och jämföra metoder och bygga en blomstrande, globalt sammankopplad praktik.

För dataforskare, kartlägg läsning till kärnämnen: modellering, feature engineering, experimentdesign, utvärderingsmått och modellövervakning. Fokusera på erkända teorier och praktiska metoder för att analysera data och lösa verkliga problem. Leverantörer som erbjuder handledningar om reproducerbara pipelines, modelltolkning och åtgärder mot partiskhet hjälper till att flytta idéer från teori till att lösa verkliga problem. Strukturera en tredelad väg: teori, praktik, driftsättning. Analysera experiment över tabell-, text- och bilddata. Dina veckovisa timmar för att läsa och köra små experiment lönar sig; gå med i internationella grupper och läsargrupper för att jämföra resultat, med världsomspännande källor och forum som accelererar inlärningen. Dolda fördomar och erkända utvärderingsmått hjälper dig att spåra framsteg.

Analytiker skapar effekt genom databerättelser, instrumentpaneler, KPI-anpassning och grundläggande styrning. Ämnen inkluderar SQL-frågor, datahantering, visualiseringstekniker och affärsmätvärden som driver beslut. Leta efter viktiga guider från leverantörer som erbjuder pragmatiska metoder för att omvandla data till handlingsbara insikter, inklusive fallstudier i detaljhandelsmiljöer. Skapa en lättläst plan byggd på tre pelare: tillgång, tolkning, kommunikation. Tillgång till världsomspännande resurser och läsargrupper hjälper dig att jämföra instrumentpaneler, lära dig av team och översätta data till mätbara åtgärder för intressenter. Spåra framsteg mot dina mål och justera ämnen när ansvaret flyttas mellan olika delar av verksamheten.

Utdrag 2-3 konkreta lärdomar per bok med snabba vinster

Schemalägg 2 konkreta åtgärdspunkter per bok i din nuvarande projektsprint och testa dem inom två veckor; spåra kundpåverkan med en enkel bock.

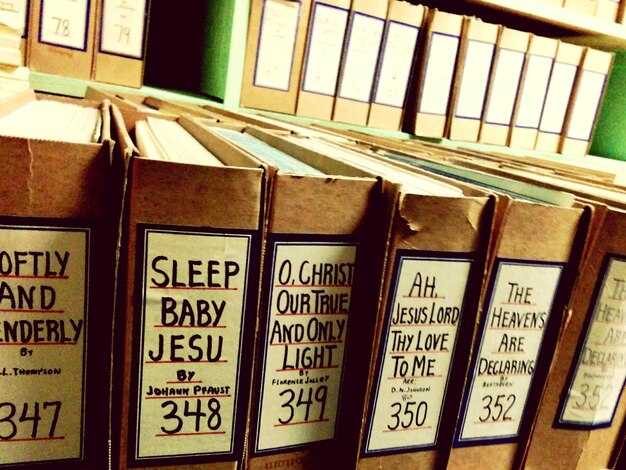

| Book | Slutsatser |

| Designing Data-Intensive Applications |

Create a versioned data contract and plan backward-compatible schema changes to minimize downtime. Add backpressure-aware pipelines and idempotent writes to prevent data loss during load spikes; monitor latency and adjust batch sizes using smart defaults. Run a 2-factor exploratory latency study and implement one targeted improvement in the data path to reduce key factors. |

| Data Science for Business |

Translate customer questions into measurable metrics; define success criteria before modeling. Frame modeling work around business outcomes and present how results drive customer value and revenue. Document the end-to-end process and present findings in a concise dashboard for stakeholders. |

| Storytelling with Data |

Redesign visuals to spotlight a single message per slide with a consistent color language. Use small multiples and clear axis labels to improve comprehension for non-technical audiences. Include a quick presenting checklist to verify readability and impact before sharing. |

| Python for Data Analysis |

Leverage pandas with Python languages and vectorized operations to cut runtime. Profile memory usage and switch to chunked processing when datasets exceed RAM. Document cleaning steps with precise language to support careergrowth and reuse in future studies. |

| Hands-On Machine Learning with Scikit-Learn, Keras & TensorFlow |

Start with a simple baseline, fixed train-test split, and track metrics in a lightweight dashboard. Apply cross-validation for robust evaluation and keep a log of experiments to avoid duplications. Plan a transitioned path from notebook exploration into production code with version control and automated tests. |

| The Pragmatic Programmer |

Automate repetitive tasks and replace manual steps with small, testable scripts. Capture decisions and ideas in a lightweight knowledge base to aid careergrowth. Schedule refactors and small improvements to reduce tech debt and improve pace. |

| The Visual Display of Quantitative Information |

Cut chartjunk and keep axes, labels, and units precise for quick reading. Choose a visualization language or languages that match the data story and test with a quick check among teammates. Favor a set of smaller visuals to explore exploratory questions beyond the numbers and capture insights. |

Link Book Concepts to the 12 Data Analysis Methods You Want to Master

Start by mapping descriptive statistics to a practical concept: collect enough data, summarize it, then set a four-week cadence to track progress and collect feedback after each session.

Pair probability and sampling with clear explaining steps: write a short video script that explains how to estimate population parameters, building a strong foundation for researchers.

Exploratory Data Analysis helps with finding relationships between variables; creating a lightweight notebook and a quick report to share in publications.

Inferential statistics and hypothesis testing: translate into a practical workflow: formulate null and alternative hypotheses, collect data, and run tests; theres a clear path from results to decisions.

Regression analysis: link to prediction and causality: define dependent and independent variables, track model performance, fit linear or logistic models, and use advanced diagnostics to interpret coefficients.

Classification: align with decision thresholds and error types: set metrics such as precision and recall, validate on holdout data, and fine-tune calibration to improve work outcomes.

Clustering: reveal natural groupings; run k-means or hierarchical methods, pick the right number of clusters with silhouette analysis, and explore how clusters relate to different data streams, including китайский texts.

Time-series analysis: capture seasonality, trend, and anomalies; build a compact notebook, track features over time, and validate forecasts with backtesting in short sessions.

Bayesian inference: reframe uncertainty with priors, update beliefs with data, and connect to publications; start with a simple model, then scale to more complex structures with advanced sampling for innovation.

Experimental design and A/B testing: plan clean experiments; randomize, perform power analysis, and pre-register; collect results and use feedback to iterate.

Data visualization: translate numbers into narrative visuals; pick the right kind of chart, keep the foundation simple, test readability, and share insights in short video clips or live sessions.

Data storytelling and communication: explain findings clearly; build relationships between results, readers, and decisions; publish the narrative as a publication or internal report; what matters for decisions is clarity; the learnsetu approach helps maintain consistency.

Set a 90-Day Action Plan to Apply Techniques in Real Projects

Choose one high-impact problem in the company and launch a 90-day program with three focused sprints: discovery, build, and measure. Build a curriculum of must-read resources and a concise set of courses that your team can follow, and set concrete metrics from the start. The ones involved should feel ownership as you translate data signals into tangible business results across the months.

Month 1: Discovery and data loading. Write a one-page problem statement tied to a business metric, map the required variables, and confirm data availability from core systems. Create a data dictionary and a minimal reproducible environment, giving the team a clear data loading plan so results can be reproduced.

Month 2: Modeling and evaluation. Select 1-2 predictive approaches aligned with data characteristics. Build an MVP model, train on historical data, and evaluate with out-of-sample tests and statistics. Perform feature engineering in small, trackable steps; document the rationale so the professionals in your group can reuse the approach. This work highlights the importance of basing decisions on verifiable evidence.

Month 3: Deployment, monitoring, and handoff. Move the model into a production-ready space within existing systems, attach it to dashboards, and establish alerts for data drift and loading performance. Create a simple runbook and a monitoring plan, then schedule a final review with stakeholders and share a concise report with the company. Capture learnings for the curriculum and offer a repeatable template for the ones who follow. thanks, youre building a capability that scales across the company for years.

Define Metrics to Measure Impact on Quality, Speed, and Decisions

Define a core set of 4 metrics that tie directly to your goal and display them on an interactive platform.

For quality, track felprocent per 1 000 ändringar, median tid att åtgärda defekter, och den percentage arbete om på grund av bristande krav. För speed, monitor cykeltid (förfrågan till leverans), ledtid, and the median dags att få insikt. För beslut, mäta beslutshastighet, adoption rate av rekommenderade åtgärder, och koppling till affärspåverkan.

Håll datahanteringen liten genom att definiera ett standarddataavtal, automatisera pipelines och använda en plattform som stöder interaktiv instrumentpaneler. Upprätta händer-om styrning med initiala kontroller så att datakvaliteten håller sig hög. Denna uppsättning öppnar dörrar för snabbare återkoppling och minskar tiden som läggs på att jaga ofullständig data. Det har redan visat sitt värde i många team och minskar ofta ledtiden.

Formulera diskussionen kring precisa frågor: vad är goal, vad problems tar vi itu med, och hur mäter vi genomslag? Koppla varje mätvärde till projekt resultat för att undvika att glida in i vanliga fåfängesiffror. I föreläsningar av maheshwari, lag som knyter mätetal till kärna målet fokusera och undvik bråk För många källor. Det finns en risk för breda instrumentpaneler; behåll det. kärna och genomförbar.

Involvera för tydlighet alla under granskningscykeln. Schemalägg korta veckovisa möten för att jämföra förväntade och faktiska resultat, diskutera median versus meningen där det är lämpligt och fånga upp återkoppling med hjälp av den interaktiva plattformen. Använd ett fåtal fokuserade föreläsningar för att förstärka inlärningen och behålla momentum.

Tillämpa detta ramverk på en platform projekt för att snabbare åtgärda problem och nå målet. Till exempel förbättringar i felprocent och cykeltid sammanhänger med högre intressentnöjdhet och snabbare anammande av rekommenderade åtgärder. Detta tillvägagångssätt hjälpte team att gå bortom fastnat cykler och öppna vägen till mätbar affärspåverkan. bred mängden datakällor blir hanterbar när du börjar med kärna metrics.

7 Must-Read Books for Data Professionals in 2025">

7 Must-Read Books for Data Professionals in 2025">